AI モニタリングでは、AI モデルに関するデータが表示されるため、AI モデルのパフォーマンスと AI アプリのパフォーマンスを分析できます。 AI モデルに関するデータは、次の 2 つの領域で見つかります。

Model inventory

: アカウント内のすべての AI モデルのパフォーマンスと完了データを表示する集中ビュー。 トークンの使用状況を分離し、全体的なパフォーマンスを追跡したり、モデルが行う個々の完了を詳しく調べたりすることができます。

Compare models

: 時間の経過に伴う 2 つのモデル間の比較パフォーマンス分析を実行します。 このページには、時間の経過に伴うモデルのパフォーマンスの集計分析データが表示されます。

one.newrelic.com > All Capabilities > AI monitoringに移動: AI モニタリングから、モデルインベントリまたはモデル比較を選択できます。

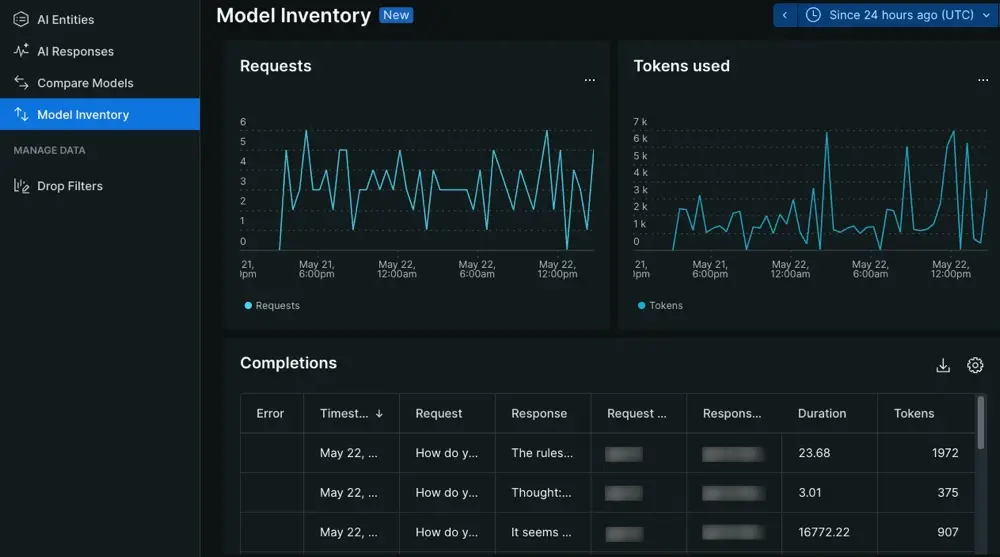

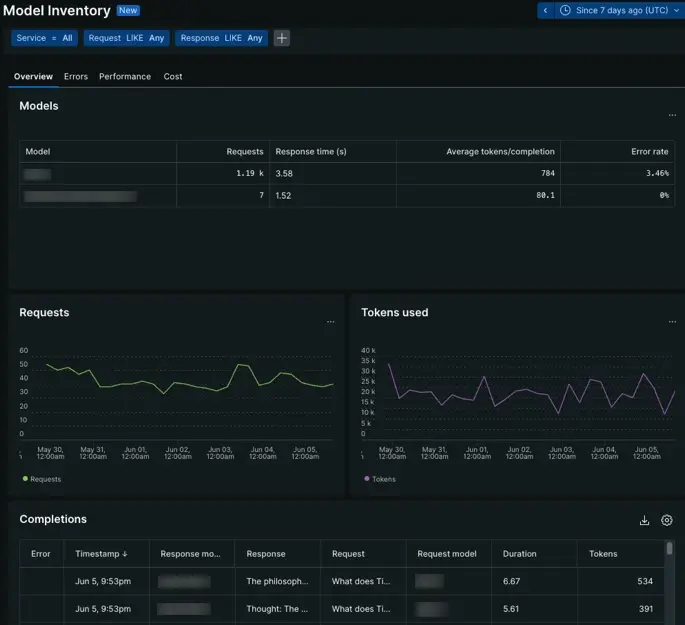

モデル在庫ページ

one.newrelic.com > All Capabilities > AI monitoring > Model inventoryに移動: AI モデルを使用してインタラクションに関するデータを表示します。

model inventoryページでは、AI モデルの全体的なパフォーマンスと使用状況について詳しく説明します。 モデルへの呼び出しからデータを分析できるため、AI モデルが AI アプリにどのように影響するかを理解できます。

概要タブから、応答時間に対するモデルへのリクエスト数を調べたり、時系列グラフを分析してモデルの動作がいつ変化したかを確認したりできます。 そこから、エラー、パフォーマンス、またはコストのタブを調査します。

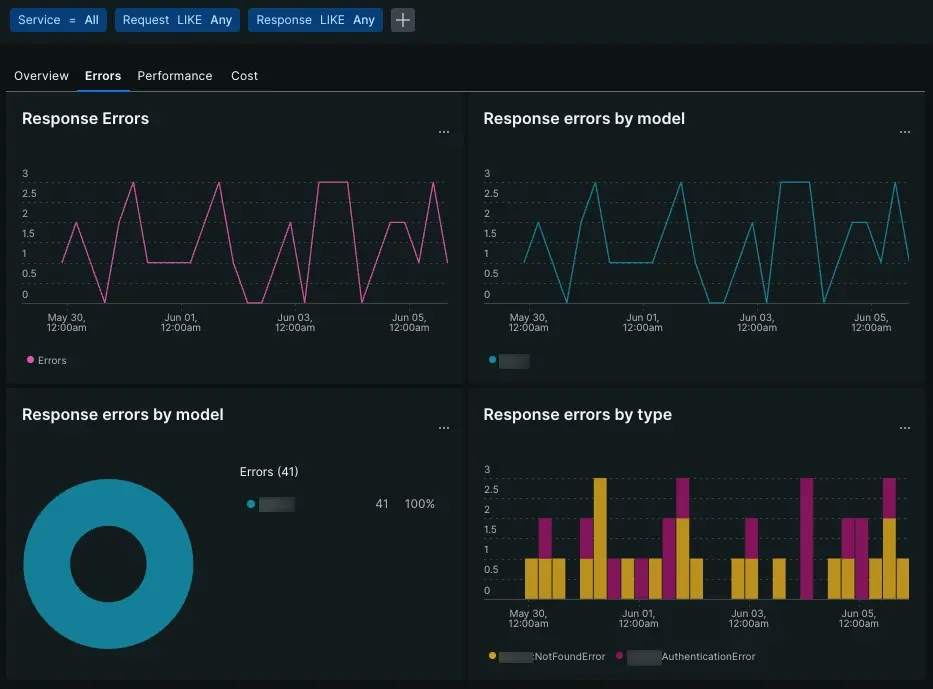

エラータブ

one.newrelic.com > All Capabilities > AI monitoring > Model inventory > Errorsに移動: AI モデルのエラーに関するデータを表示します。

エラー タブでは、時系列グラフと表を使用してモデル エラーを整理します。

Response errors

: AI モデルから発生するエラーの総数を追跡します。

Response errors by model

: 特定のモデルが平均してより多くのエラーを生成するかどうか、または特定のエラーがモデル全体で発生しているかどうかを判断します。

Response errors by type

: 特定のエラーが発生する頻度を表示します。

Errors table

: リクエストとレスポンスのコンテキストでエラーの種類とメッセージを表示します。

パフォーマンスタブ

one.newrelic.com > All Capabilities > AI monitoring > Model inventory > Performanceに移動: AI モデルのパフォーマンスに関するデータを表示します。

「パフォーマンス」タブでは、すべてのモデルにわたる応答とリクエストのメトリックが集計されます。 円グラフを使用して、リクエストの処理や応答の作成に最も時間がかかるモデルの概要を確認したり、時系列グラフを参照してリクエストまたは応答時間の増加を追跡したりできます。 パフォーマンス チャートを使用して、モデル全体の外れ値を見つけることができます。

コストタブ

one.newrelic.com > All Capabilities > AI monitoring > Model inventory > Costに移動: AI モデルのコストに関するデータを表示します。

コスト タブでは、時系列グラフと円グラフを組み合わせて、モデル間のコスト要因を特定します。 プロンプトまたは補完から生成されたトークンの数、または特定のモデルが他のモデルよりも平均的にコストが高いかどうかを判断します。

Tokens used and token limit

: モデルが特定のトークン制限に近づく頻度を評価します。

Total tokens by models

: どのモデルが平均して最も多くのトークンを使用するかを判断します。

Total usage by prompt and completion tokens

: 完了ごとに使用されるトークンに対して、モデルが受け入れるプロンプトから取得されるトークンの比率を把握します。

コストを理解することで、AI アプリが 1 つ以上のモデルを使用する方法を改善し、AI ツールチェーンのコスト効率を高めることができます。

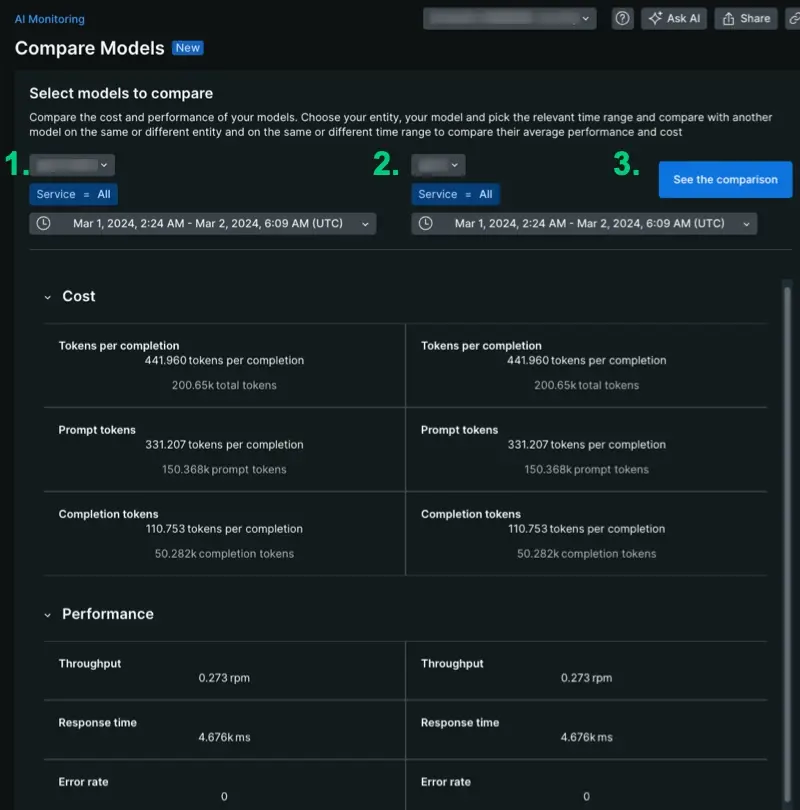

モデル比較ページ

one.newrelic.com > All Capabilities > AI monitoring > Model comparisonに移動: スタック内のさまざまな AI モデルに関するデータを比較します。

モデル比較ページでは、AI モニタリング データが整理され、比較分析に役立ちます。 このページでは、モデル比較データを単一のアカウントに限定し、1 つ以上のアプリにわたるモデルのコストとパフォーマンスに関する集計データを提供します。 データを生成するには:

- ドロップダウンからモデルを選択してください。

- 特定のアプリのコンテキストでパフォーマンスを確認するには、スコープを 1 つのサービスに限定します。また、クエリを

Service = Allに限定して、モデルが平均的にどのように動作するかを確認します。 - 時間を選択してください。 このツールは柔軟性が高く、異なる期間間で比較できるため、導入前と導入後のパフォーマンスやコストの変化を確認できます。

モデルのパフォーマンスを比較する

one.newrelic.com > All Capabilities > AI monitoring > Model comparisonに移動: スタック内のさまざまな AI モデル間のパフォーマンスを比較します。

比較分析を開始するには、特定のサービス、モデル、および時間範囲を選択します。 モデルを比較する場合、独自の設定に応じて、時間の経過に伴って集計されたさまざまなメトリックを評価できます。 比較分析のユースケース例をいくつか示します。

- 同じサービス内の 2 つのモデルを比較します。サービス X は 1 週目にモデル A を使用しますが、2 週目にはモデル B を使用します。 サービス X を選択し、モデル A を選択して、第 1 週の日付を設定することで、パフォーマンスを比較できます。 2 番目のページで、サービス X を選択し、モデル B を選択して、2 週目の日付を設定します。

- 1 つのモデルのパフォーマンスを時間の経過とともに比較します。サービス X を選択し、モデル A を選択して、第 1 週の日付を設定します。 2 番目のページで、サービス X を選択し、モデル A を選択して、2 週目の日付を設定します。

- 2 つの異なるサービスでモデルのパフォーマンスを評価する: 2 つの異なるモデルを使用する 2 つの異なるアプリケーションがあります。 先月の合計トークンを比較するには、特定のサービスと特定のモデルの関連する引数を選択し、同じ期間の日付を設定します。

- 2 つのモデルを比較する: モデル A を使用するアプリケーションがあり、モデル A をモデル B と比較して測定するとします。ユーザーのプロンプトごとに、モデル B をバックグラウンド プロセスとして呼び出します。 同じサービスで同じ期間にモデル A とモデル B のパフォーマンスを比較します。

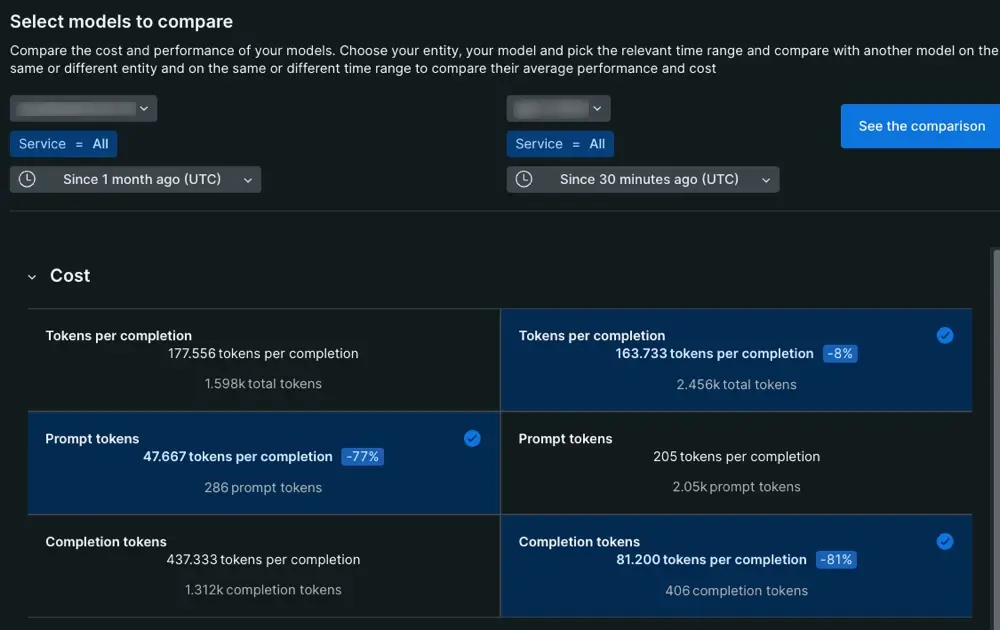

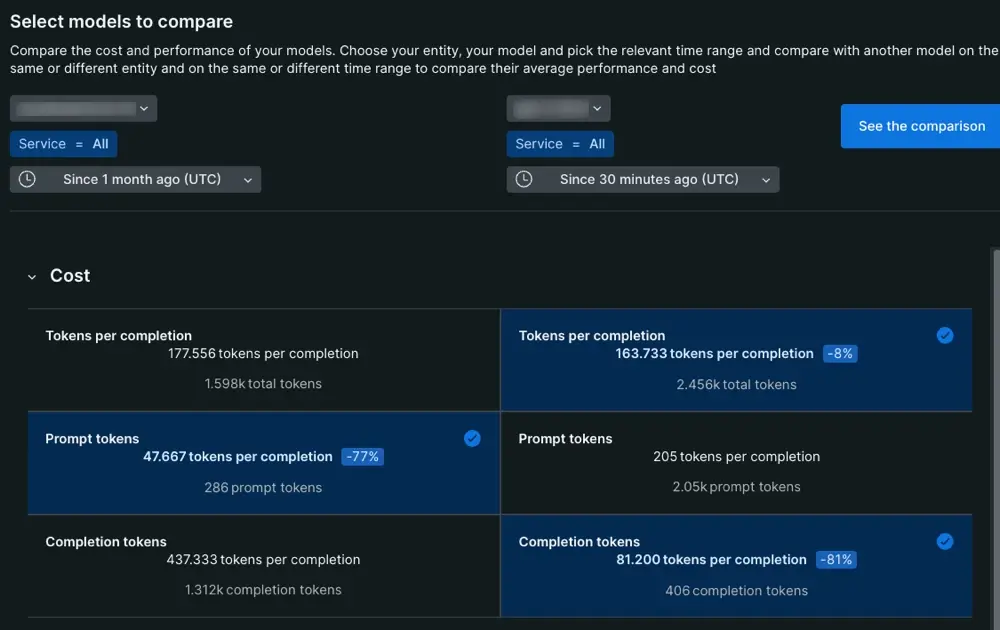

モデルコストを比較する

one.newrelic.com > All Capabilities > AI monitoring > Model comparisonに移動: スタック内のさまざまな AI モデル間のコストを比較します。

モデルのコスト列は、完了イベントを 2 つの部分に分類します。モデルに与えられるプロンプトと、モデルがエンドユーザーに提供する最終応答です。

Tokens per completion

: すべての完了イベントのトークンの平均。

Prompt tokens

: プロンプトのトークンの平均。 このウイルス平均には、プロンプト エンジニアとエンドユーザーによって作成されたプロンプトが含まれます。

Completion tokens

: エンドユーザーに配信されるレスポンスを生成する際にモデルによって消費されるウイルスの数。

この列を分析する場合、完了トークンとプロンプト トークンの値は、完了ごとのトークンの値と等しくなる必要があります。

次は何ですか?

データの検索方法がわかったので、AI モニタリングが提供する他の機能を探索してみましょう。

- AI アプリのパフォーマンスを分析したいですか? AI アプリ応答ページに関するドキュメントをご覧ください。

- 機密情報について懸念がありますか? ドロップ フィルターの設定方法を学習します。

- アプリの AI 応答に関するユーザー フィードバック情報を New Relic に転送する場合は、手順に従ってアプリ コードを更新し、UI でユーザー フィードバックを取得してください。